- Szerző Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:48.

- Utoljára módosítva 2025-01-22 17:26.

Adatok lokalizálása ban ben Hadoop . Vegyük a Wordcount minta példát, ahol a legtöbb szó 5 Lacs vagy több alkalommal ismétlődött. Ebben az esetben a Mapper fázis után minden egyes leképező kimenetben 5 Lacs tartományban lesznek szavak. Ezt a teljes folyamatot, amely a Mapper kimenetének az LFS-ben tárolja, úgy hívják Adatok lokalizálása.

Ezt szem előtt tartva, mi az adathonosítás a Hadoopban?

A koncepció Adat helységben Hadoop adatok helységben MapReduce arra a képességre utal, hogy a számítást a ténylegeshez közel lehet mozgatni adat a csomóponton található, ahelyett, hogy nagyot mozogna adat a számításhoz. Ez minimálisra csökkenti a hálózati torlódást és növeli a rendszer teljes átviteli sebességét.

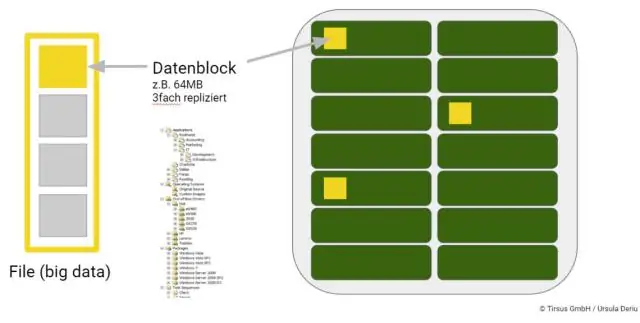

Illetve hogyan tárolódnak a big data? A legtöbb ember automatikusan társítja a HDFS-t vagy a Hadoop elosztott fájlrendszert a Hadoop-pal adat raktárak. A HDFS kisebb blokkokból álló fürtökben tárolja az információkat. Ezek a blokkok tárolva helyszíni fizikai tárolás egységek, például belső lemezmeghajtók.

Csak hát, hogyan tárolódnak az adatok a Hadoopban?

Rajta Hadoop klaszter, a adat A HDFS és a MapReduce rendszer a fürt minden gépén megtalálható. Adat van tárolva ban ben adat blokkok a DataNodes-on. A HDFS ezeket reprodukálja adat blokkok, általában 128 MB méretű, és elosztja őket, így replikálódnak több csomóponton belül a fürtben.

Hogyan tárolódnak a fájlok a HDFS-ben?

HDFS kiteszi a fájlt rendszer névterét, és lehetővé teszi a felhasználói adatok használatát tárolva ban ben fájlokat . Belsőleg a fájlt fel van osztva egy vagy több blokkra, és ezek a blokkok tárolva egy DataNodes halmazban. A NameNode végrehajtódik fájlt rendszernévtér-műveletek, például nyitás, bezárás és átnevezés fájlokat és könyvtárakat.

Ajánlott:

Hogyan érhető el a konszenzus a blokkláncban?

Mi az a konszenzusmechanizmus? A konszenzusos mechanizmus egy hibatűrő mechanizmus, amelyet számítógépes és blokklánc-rendszerekben használnak, hogy elérjék a szükséges megegyezést egyetlen adatértékről vagy a hálózat egyetlen állapotáról az elosztott folyamatok vagy többügynökes rendszerek között, például kriptovalutáknál

Mi a különbség a csoportos adatok és a csoportosítatlan adatok között?

Mindkettő hasznos adatforma, de a különbség közöttük az, hogy a csoportosítatlan adatok nyers adatok. Ez azt jelenti, hogy csak most gyűjtöttük össze, de nincs csoportba vagy osztályba rendezve. Másrészt a csoportosított adatok olyan adatok, amelyeket a nyers adatokból csoportokba rendeztek

Hogyan érhető el az adatok absztrakciója?

Az absztrakció egy nagyobb készletből választ ki adatokat, hogy csak az objektum releváns részleteit jelenítse meg. Segít csökkenteni a programozás bonyolultságát és erőfeszítéseit. A Java nyelven az absztrakció absztrakt osztályok és interfészek segítségével valósul meg. Ez az OOP egyik legfontosabb fogalma

Hogyan működik a HBase a Hadoopban?

A HBase a Google nagy táblájához hasonló adatmodell, amelyet úgy terveztek, hogy véletlenszerű hozzáférést biztosítson nagy mennyiségű strukturált vagy strukturálatlan adathoz. A HBase a Hadoop ökoszisztéma fontos összetevője, amely kihasználja a HDFS hibatűrési funkcióját. A HBase valós idejű olvasási vagy írási hozzáférést biztosít a HDFS-ben tárolt adatokhoz

Hogyan érhető el a többszálú feldolgozás a Pythonban?

A szálfűzésnél az egyidejűség több szál használatával érhető el, de a GIL miatt egyszerre csak egy szál futhat. A többfeldolgozás során az eredeti folyamatot több gyermekfolyamattá alakítják, amelyek megkerülik a GIL-t. Minden gyermekfolyamatnak lesz egy másolata a teljes program memóriájából